Haciendo un poco de historia, la Calidad fue evolucionando notablemente con el paso del tiempo. El objetivo principal siempre fue el mismo: la satisfacción del cliente, el cumplimiento de las especificaciones. Entre la inspección visual basada en el criterio propio del fabricante y la mejora continua de las organizaciones actuales, se fueron incorporando diferentes conceptos fundamentales que harían lo que hoy conocemos como Calidad.

|

| Edwards, Shewhart, Deming y Juran Cuatro personalidades fundamentales en la evolución de la Calidad |

Se pueden definir claramente cuatro generaciones bien marcadas:

La Primera Generación: El Control de la Calidad por Inspección

Para garantizar que el cliente no recibiese productos defectuosos, se realizaba una inspección visual a cada uno de los productos fabricados. Sólo se trabajaba sobre los efectos. Existían claramente dos desventajas de este método: el porcentaje de rechazos era altísimo y los criterios para considerar si un producto era defectuoso o no los definía el propio fabricante (lo cual no necesariamente coincidía con la expectativa del cliente o con algún estándar preestablecido).

La Segunda Generación: Aseguramiento de la Calidad

Aquí aparecieron conceptos importantísimos, que hoy se mantienen vigentes:

- En primer lugar, se comenzaron a utilizar instrumentos de medición para la evaluación del producto final y productos intermedios.

- Por otro lado se establecieron métodos de muestreo, evitando la inspección del 100% de los productos fabricados reduciendo los tiempos y los costos operativos.

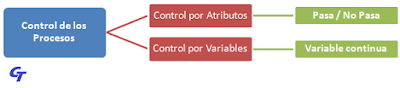

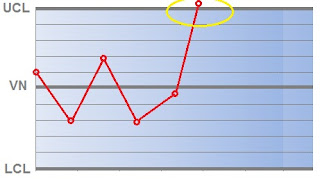

- Se comenzaron a utilizar las gráficas de control, punto de partida del Control Estadístico de la Calidad (Walter A. Shewhart fue su principal diseñador).

Sumado a esto, dos personalidades muy influyentes comenzaron a brindar importantísimos conceptos:

- George D. Edwards definió alrededor de 1946 el concepto de Aseguramiento de la Calidad que establece que:

- La Calidad es la consecuencia de la actividad de todos los empleados, pero es responsabilidad de la Dirección.

- Los controles no se deben realizar únicamente sobre el producto final sino que deben comenzar desde la recepción de la materia prima, incluyendo los procesos intermedios. Se deben establecer, además, los puntos críticos de control.

- W. Edwards Deming tomó los conceptos de Shewhart de Control Estadístico, difundiéndolos y aplicándolos en la industria japonesa. Deming también fue uno de los socios fundadores de una organización clave en el Aseguramiento de la Calidad: la ASQC (Sociedad Americana de Control de la Calidad) que inició sus actividades en 1946. En la década del 50, Deming impartió sus conocimientos estadísticos en varias empresas de Estados Unidos y Japón, país que comenzó a convertirse en potencia industrial mundial a partir de esta influencia. En su análisis Deming destacó la responsabilidad de la Gerencia, de la Alta Dirección, en los resultados.

La Tercera Generación: Calidad Total

Sumado al aporte de Deming, Joseph M. Juran reforzó durante sus visitas a Japón la importancia del compromiso de la Alta Dirección en los resultados de la Calidad. La calidad empieza y termina en el cliente.

Con el paso de los años se fue entendiendo que la calidad no sólo era una cuestión de la línea de manufactura, del área productiva, sino que estaban involucradas todas las áreas de la organización. El involucramiento de todo el personal en la calidad, así como el desarrollo de proveedores, llevaron al concepto de Calidad Total.

La Cuarta Generación: Mejora Continua de los Procesos

Aquí aparecen conceptos de suma importancia: la formación sistémica del personal como base de la mejora de los procesos y la reducción de los costos que esto conlleva. Crece, además, la interrelación entre áreas de la organización.

Se le da mayor importancia a las expectativas del cliente, reduciendo notablemente la brecha con él y poniéndolo en la cima de la pirámide.

Se le da mayor importancia a las expectativas del cliente, reduciendo notablemente la brecha con él y poniéndolo en la cima de la pirámide.

|

| Las 4 Generaciones de la Calidad |